- Giảm 10% phí tải tài liệu khi like và share website

- Tặng 1 bộ slide thuyết trình khi tải tài liệu

- Giảm 5% dịch vụ viết thuê luận văn thạc sĩ của Luận Văn A-Z

- Giảm 2% dịch vụ viết thuê luận án tiến sĩ của Luận Văn A-Z

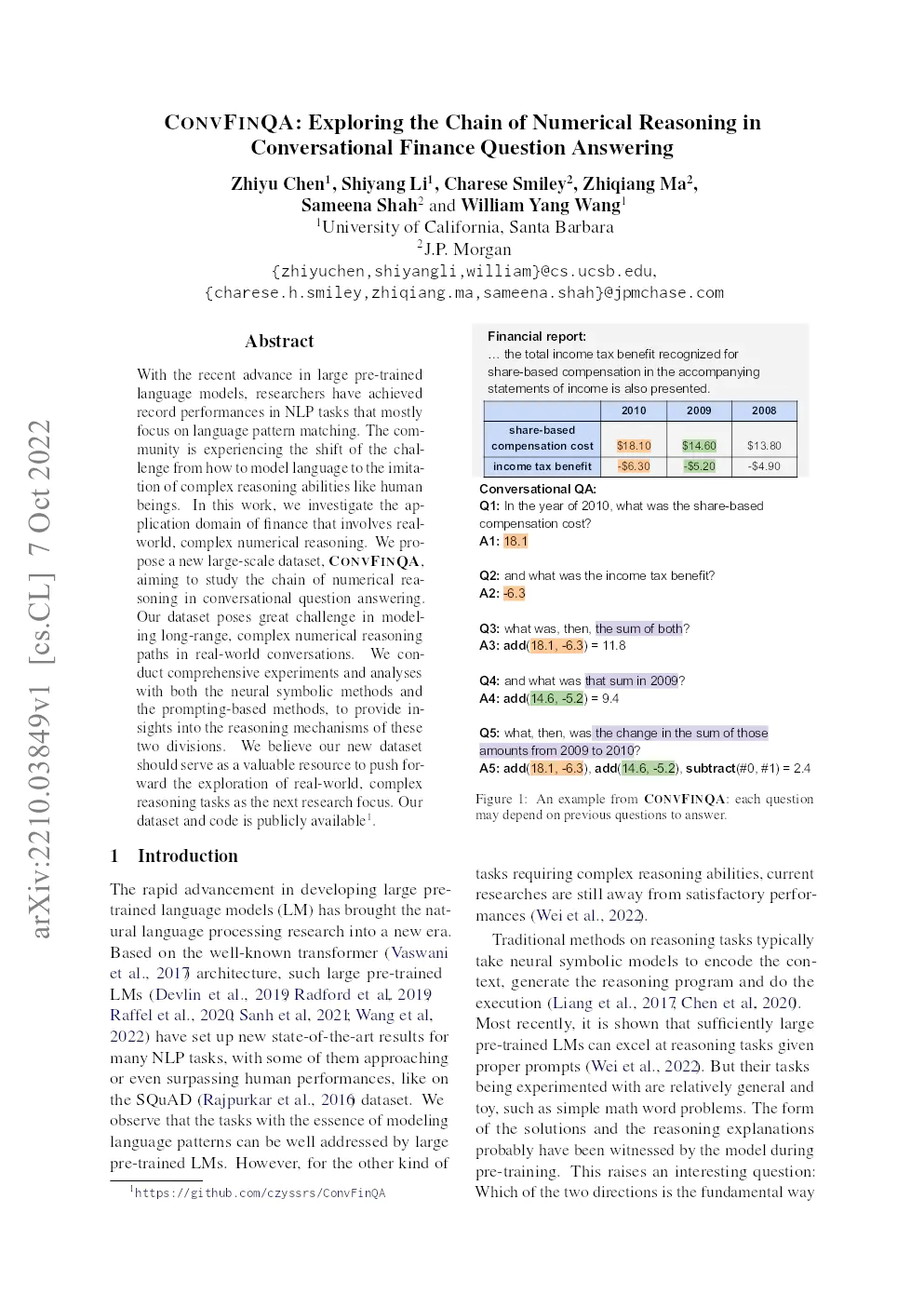

Convfinqa: Exploring The Chain Of Numerical Reasoning In Conversational Finance Question Answering

Giá gốc là: 50.000 VNĐ.0 VNĐGiá hiện tại là: 0 VNĐ.

Nghiên cứu này khám phá việc áp dụng các mô hình ngôn ngữ tiền huấn luyện lớn trong lĩnh vực tài chính, tập trung vào khả năng suy luận số học phức tạp. Công trình giới thiệu CONVFINQA, một bộ dữ liệu quy mô lớn mới, được thiết kế để nghiên cứu chuỗi suy luận số học trong trả lời câu hỏi đàm thoại. Bộ dữ liệu này đặt ra thách thức lớn trong việc mô hình hóa các đường dẫn suy luận số học phức tạp, tầm xa trong các cuộc hội thoại thực tế. Các thử nghiệm toàn diện sử dụng cả phương pháp tượng trưng thần kinh và phương pháp dựa trên gợi ý, cung cấp những hiểu biết sâu sắc về cơ chế suy luận của hai hướng tiếp cận này. Nghiên cứu này nhằm mục đích thúc đẩy việc khám phá các nhiệm vụ suy luận phức tạp trong thế giới thực như một trọng tâm nghiên cứu tiếp theo.

1. Thông tin Nghiên cứu khoa học

- Tên nghiên cứu (Tiếng Anh): CONVFINQA: Exploring the Chain of Numerical Reasoning in Conversational Finance Question Answering

- Tên nghiên cứu (Tiếng Việt): CONVFINQA: Khám phá Chuỗi Suy luận Số trong Trả lời Câu hỏi Tài chính Hội thoại

- Tác giả: Zhiyu Chen, Shiyang Li, Charese Smiley, Zhiqiang Ma, Sameena Shah và William Yang Wang

- Số trang file pdf: 23

- Năm: 2022

- Nơi xuất bản: arXiv

- Chuyên ngành học: Xử lý ngôn ngữ tự nhiên (Natural Language Processing – NLP)

- Từ khoá: Conversational Question Answering (Hỏi đáp hội thoại), Numerical Reasoning (Suy luận số), Finance (Tài chính), Dataset (Tập dữ liệu), Large Language Models (Mô hình ngôn ngữ lớn).

2. Nội dung chính

Bài viết giới thiệu một tập dữ liệu mới có tên CONVFINQA, tập trung vào việc nghiên cứu chuỗi suy luận số trong bài toán trả lời câu hỏi tài chính hội thoại. Bài viết nhấn mạnh rằng, mặc dù các mô hình ngôn ngữ lớn (LLMs) đã đạt được những tiến bộ đáng kể trong các tác vụ NLP chủ yếu tập trung vào việc khớp mẫu ngôn ngữ, nhưng khả năng mô phỏng các khả năng suy luận phức tạp như con người vẫn còn là một thách thức lớn. Lĩnh vực tài chính, với các yêu cầu về suy luận số phức tạp và thực tế, được chọn làm miền ứng dụng để điều tra khả năng này.

CONVFINQA bao gồm 3.892 cuộc hội thoại với 14.115 câu hỏi, được xây dựng bằng cách mô phỏng luồng hội thoại thông qua việc phân tách và kết hợp các câu hỏi đa bước từ tập dữ liệu FinQA hiện có. Các chuyên gia được thuê để soạn các câu hỏi cho mỗi lượt hội thoại dựa trên luồng hội thoại mô phỏng. Mục tiêu của tập dữ liệu là thúc đẩy việc khám phá các tác vụ suy luận phức tạp, thực tế. Bài viết trình bày các thí nghiệm và phân tích toàn diện sử dụng cả phương pháp tượng trưng thần kinh (neural symbolic methods) và phương pháp dựa trên prompting (prompting-based methods) để cung cấp thông tin chi tiết về cơ chế suy luận của hai hướng tiếp cận này.

Bài viết so sánh CONVFINQA với các tập dữ liệu hiện có, làm nổi bật sự khác biệt của nó trong việc tập trung vào chuỗi suy luận số phức tạp trong các cuộc hội thoại tài chính. Các tập dữ liệu trước đây thường tập trung vào các khía cạnh khác của QA hội thoại, chẳng hạn như điều hướng bảng, suy luận trên Knowledge Graph (KG), tham chiếu hoặc các tính toán số đơn giản. Bài viết trình bày chi tiết quy trình xây dựng tập dữ liệu, bao gồm mô phỏng luồng QA hội thoại và soạn thảo câu hỏi. Quá trình mô phỏng bao gồm hai loại hội thoại: hội thoại đơn giản, bắt nguồn từ việc phân tách một câu hỏi đa bước và hội thoại hỗn hợp, kết hợp các câu hỏi từ hai câu hỏi đa bước. Các chuyên gia được thuê để chuyển đổi các lược đồ hội thoại thành các câu hỏi thực tế, cho phép bỏ qua các lượt không tự nhiên và đảm bảo tính mạch lạc tổng thể.

Phân tích tập dữ liệu CONVFINQA cho thấy những thách thức đáng kể liên quan đến việc học chuỗi suy luận số trong các lượt hội thoại. Các chuyên gia được yêu cầu xác định khoảng cách phụ thuộc dài nhất cần thiết để trả lời một câu hỏi, và kết quả cho thấy hơn 60% câu hỏi có sự phụ thuộc vào các câu hỏi trước đó. Hơn nữa, phân tích cho thấy 65% câu hỏi trong nửa sau của các cuộc hội thoại hỗn hợp phụ thuộc vào các câu hỏi từ nửa đầu, điều này nhấn mạnh sự phức tạp của việc xây dựng chuỗi suy luận. Đánh giá chất lượng dữ liệu cho thấy rằng các chuyên gia đạt được độ chính xác thực thi trung bình là 89,44% và độ chính xác chương trình là 86,34%, trong khi những người không có chuyên môn chỉ đạt được độ chính xác thấp hơn đáng kể, điều này cho thấy kiến thức chuyên môn cần thiết để giải quyết tập dữ liệu.

Bài viết trình bày các thí nghiệm với các phương pháp tượng trưng thần kinh, sử dụng mô hình FinQANet và các mô hình sinh như GPT-2 và T5. Kết quả cho thấy FinQANet, một kiến trúc được thiết kế đặc biệt với khả năng bảo tồn cấu trúc của chương trình, vượt trội hơn các mô hình sinh đơn lẻ. Tuy nhiên, vẫn còn một khoảng cách đáng kể so với hiệu suất của chuyên gia, cho thấy không gian cần cải thiện. Phân tích chi tiết cho thấy rằng các lượt chọn số là dễ trả lời nhất, trong khi các cuộc hội thoại hỗn hợp khó học hơn các cuộc hội thoại đơn giản, đặc biệt là nửa sau của các cuộc hội thoại hỗn hợp. Các lượt sau trong cuộc hội thoại có xu hướng khó hơn do sự phụ thuộc suy luận dài hơn. Phân tích lỗi thủ công cho thấy mô hình hoạt động tốt trong các câu hỏi chọn số và xác định khi nào nên loại bỏ ngữ cảnh trước đó, nhưng gặp khó khăn với việc thiếu kiến thức miền, chuỗi suy luận dài và tạo chương trình chính xác.

Tiếp theo, bài viết khám phá các phương pháp dựa trên prompting sử dụng mô hình GPT-3 text-davinci-002 cho học few-shot. Do hạn chế về độ dài, một mô hình truy xuất được sử dụng để chọn các sự kiện hỗ trợ. Kết quả cho thấy rằng GPT-3 hoạt động kém hơn so với các phương pháp tượng trưng thần kinh được đào tạo đầy đủ, ngay cả khi được cung cấp các sự kiện hỗ trợ chính xác. Các thí nghiệm khác nhau được thực hiện với các định dạng prompting khác nhau, bao gồm chỉ trả lời, tạo chương trình bằng DSL gốc, tạo chương trình bằng DSL thông thường và prompting chuỗi suy nghĩ (Chain-of-Thought – CoT). GPT-3 có thể tự thực hiện các phép tính đơn giản, nhưng gặp khó khăn với các phép tính phức tạp và dường như gặp khó khăn trong việc tìm hiểu các mô hình tác vụ phức tạp mới. Chương trình có định dạng quen thuộc (Program-normal) hoạt động tốt hơn chương trình có định dạng gốc (Program-original), vì nó quen thuộc hơn với GPT-3 trong quá trình đào tạo trước. CoT prompting hoạt động thậm chí còn tệ hơn so với việc chỉ tạo chương trình, có lẽ vì mô hình chỉ đơn giản là bắt chước các bước suy luận được đưa ra trong các ví dụ mà không thực sự hiểu ngữ cảnh.

Để hiểu rõ hơn về cách viết các bài nghiên cứu khoa học bạn có thể tham khảo 15 prompt chatgpt hỗ trợ viết các bài nghiên cứu khoa học.

3. Kết luận

Nghiên cứu đã giới thiệu CONVFINQA, một tập dữ liệu mới thách thức việc mô phỏng khả năng suy luận của con người trong các môi trường thực tế phức tạp. Các thí nghiệm với các mô hình tượng trưng thần kinh và học few-shot dựa trên prompting cho thấy rằng cả hai cách tiếp cận vẫn còn một khoảng cách so với hiệu suất của chuyên gia, điều này làm nổi bật những khó khăn của nhiệm vụ này. Phương pháp tượng trưng thần kinh sử dụng các kiến trúc được thiết kế đặc biệt để học các mẫu đồng xuất hiện bằng dữ liệu đào tạo quy mô lớn, trong khi phương pháp dựa trên prompting gợi lại bộ nhớ riêng về việc xây dựng quy trình suy luận với kích hoạt các lời nhắc. Nghiên cứu chỉ ra rằng các mô hình ngôn ngữ lớn (LLMs) có thể không hoạt động tốt khi gặp phải các mô hình tác vụ phức tạp mới cho các miền mới. Các tác giả suy đoán rằng về mặt lý thuyết, nhiều mô hình tác vụ có thể được mã hóa vào các LLM, miễn là quy trình suy luận có thể được minh họa rõ ràng bằng ngôn ngữ. Tuy nhiên, đối với các miền hoặc tác vụ chuyên môn cao, việc thiết kế các mô hình cụ thể có xu hướng thực tế và hiệu quả hơn. Cuối cùng, nghiên cứu này nhấn mạnh sự cần thiết phải nghiên cứu thêm để khám phá các giới hạn của các LLM trong các tác vụ suy luận và để phát triển các mô hình hiệu quả hơn cho các tác vụ suy luận phức tạp trong thế giới thực. Để làm được một bài nghiên cứu khoa học chất lượng, việc tìm kiếm và tải xuống các bài báo khoa học là vô cùng quan trọng, bạn có thể tham khảo hướng dẫn download miễn phí bài báo khoa học từ trang ScienceDirect. Bên cạnh đó, để hiểu rõ hơn về các phương pháp nghiên cứu bạn có thể tìm hiểu thêm về phương pháp thu thập dữ liệu sơ cấp trong nghiên cứu khoa học.